Intelligenza Artificiale tra affari, etica e regole Ue

di Max Zanetti

E’ di pochi giorni fa l’approvazione, da parte dell’Unione Europea, di un documento chiamato “Nuove Linee Guida sull’Intelligenza Artificiale”, una sorta di codice etico per tutti gli sviluppi futuri legati a queste nuove tecnologie.

Il primo dei princìpi contenuti nel documento prevede che «ci sia sempre un controllo umano, perché l’obiettivo è migliorare l’agire dell’uomo e i suoi diritti e non ridurre la sua autonomia».

Chi, diversamente dal sottoscritto, ha amato la fantascienza sia come genere letterario che cinematografico negli anni 70 e 80, saprà trovare molti riferimenti a quello che un tempo era solo finzione.

La notizia dell’approvazione di questo documento segue di pochi giorni un altro episodio che ha destato interesse: la chiusura, dopo sole due settimane di lavori, del Comitato Etico per l’intelligenza artificiale, voluto e creato da Google a fine marzo. Il comitato è stato chiuso dopo le proteste di oltre duemila dipendenti di Google, a causa della designazione, all’interno del Comitato stesso, di Kay Coles James, membro del think tank conservatore The Heritage Foundation che ha espresso più volte posizioni contro la comunità LGBT e ha supportato politiche restrittive nei confronti dell’immigrazione.

Siamo ben lontani da macchine in grado di avere una conoscenza evoluta del mondo che le circonda; dunque parlare di macchine che hanno una coscienza è, allo stato attuale, totalmente irrealistico. Ergo, la questione sulla quale discutere, nel medio termine, non sarà tanto quella di mettere l’uomo prima della macchina quanto di fare in modo che l’uomo dietro la macchina sia guidato, ancora una volta, da princìpi etici. Brad Smith, presidente di Microsoft, ha sostenuto questo tema alla Data Science Conference, tenutasi alla Columbia University, NYC, la settimana scorsa. Uno dei campi di ricerca più avanzati e promettenti legati alle tecnologie di Machine Learning è il riconoscimento facciale e uno dei suoi campi di applicazione è per usi militari e di difesa. Esiste tuttavia un problema legato a tali software: i database usati per istruire le macchine al riconoscimento facciale sono biased, cioè statisticamente rappresentano un campione distorto, perché contengono prevalentemente foto di soggetti bianchi e caucasici. E questo mi ha fatto tornare alla memoria la grande raccolta di foto di Instagram qualche mese fa, resa famosa dal fatto che molte celebrità hanno partecipato postando le loro foto attuali e quelle di 10 anni prima. Facile studiare a questo punto come cambiano i tratti somatici delle persone dopo un invecchiamento di 10 anni! Per fortuna a questo c’è rimedio e si chiama adversal example. Nella sua complessità applicativa l’idea è semplice: mascherare una foto reale, a esempio di un animale, con una foto che rappresenta una nuvola di punti impercettibili all’occhio umano ma che inducono la macchina a classificare la foto in modo sbagliato, come si trattasse di un altro animale.

Un po’ di privacy ancora l’abbiamo. Teniamocela stretta. Ultima cosa: un punto a favore di Microsoft. La società ha deciso di estendere le regole della normativa europea sulla privacy a tutti i suoi prodotti venduti nel mondo.

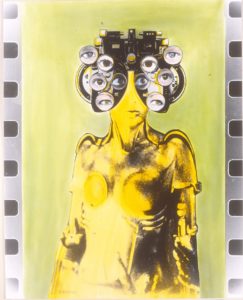

L’IMMAGINE – scelta dalla “bottega” – è di Giuliano Spagnul.